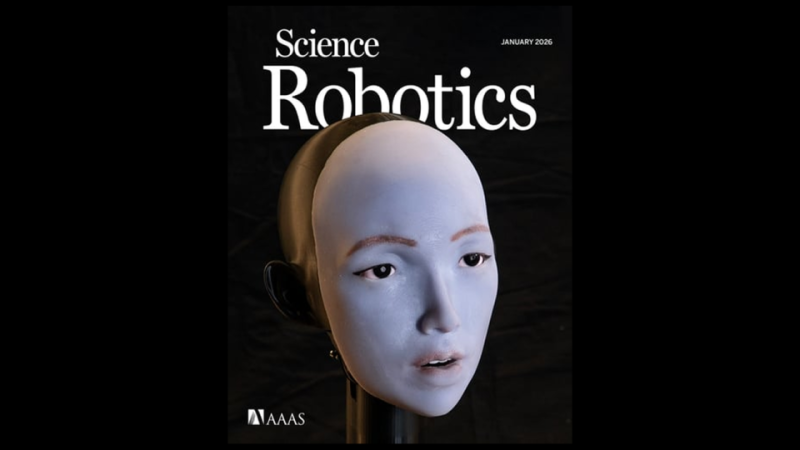

In einem neuen Schritt, der Roboter der menschlichen Welt näherbringt, haben Forscher einen bemerkenswerten technologischen Durchbruch bekannt gegeben: die Entwicklung eines Roboters, der eine der komplexesten menschlichen Gesichtsbewegungen erlernen und beherrschen kann – die Lippenbewegung beim Sprechen und Singen.

Dieser Fortschritt könnte einen Wendepunkt für die Zukunft humanoider Roboter darstellen, zumal fast die Hälfte der menschlichen Aufmerksamkeit bei direkter Interaktion auf Gesichtsausdrücke und Lippenbewegungen gerichtet ist. Das macht uns sehr empfindlich für Fehler oder mangelnde Harmonie in diesen Bewegungen.

Bis vor kurzem hatten Roboter große Schwierigkeiten, die natürliche Art und Weise, wie Menschen ihre Lippen bewegen, nachzuahmen, und wirkten oft unkoordiniert oder „seltsam“.

Dieses Phänomen ist wissenschaftlich als das „Uncanny Valley“ bekannt – das Gefühl des Unbehagens, das einen Menschen überkommt, wenn er etwas sieht, das fast menschlich erscheint, sich aber nicht völlig natürlich bewegt oder verhält. Diese Realität könnte sich jedoch bald ändern.

Wie hat der Roboter gelernt, seine Lippen zu bewegen?

Am Mittwoch stellten Ingenieure einen neuen Roboter vor, dem es erstmals gelang, menschliche Lippenbewegungen während des Sprechens und sogar Singens zu erlernen und nachzuahmen.

Der Roboter lernte, 26 Motoren in seinem Gesicht zu nutzen, indem er stundenlang Videos auf YouTube ansah. Anschließend übte er die Nachahmung menschlicher Lippenbewegungen, indem er sein Spiegelbild beobachtete.

In einer Studie zeigten die Forscher, wie der Roboter in der Lage wurde, Wörter in mehreren Sprachen auszusprechen und sogar ein komplettes Lied aus seinem ersten Album mit dem Titel „hello world“ zu singen, das mit Hilfe künstlicher Intelligenz erstellt wurde.

Die Ingenieure bestätigen, dass sich die Leistung des Roboters mit der Zeit verbessern wird: „Je mehr er mit Menschen interagiert, desto besser wird seine Leistung.“

Trotz dieses bemerkenswerten Fortschritts räumt das Forschungsteam ein, dass die Lippenbewegung noch nicht perfekt ist. Der Roboter hatte Schwierigkeiten mit einigen starken Lauten wie dem Buchstaben „B“ und solchen, die einen Lippenschluss erfordern, wie dem „W“. Man geht jedoch davon aus, dass sich diese Probleme mit mehr Training und Lernen verbessern werden.

Es wird angemerkt, dass sich ein Großteil der aktuellen Forschung zu humanoiden Robotern auf die Bewegung von Beinen und Händen zum Gehen oder Greifen von Objekten konzentriert. Die Gefühlsäußerung durch das Gesicht ist jedoch nicht weniger wichtig, insbesondere bei Anwendungen, die direkte Interaktion mit Menschen erfordern.

Die Integration der Fähigkeit zur Lippensynchronisation mit interaktiven KI-Systemen könnte der Mensch-Roboter-Beziehung eine völlig neue Dimension verleihen und die Interaktion natürlicher und menschlicher machen.

Forscher erwarten, dass diese Roboter mit „lebendigen Gesichtern“ breite Anwendung in Bereichen wie diesen finden werden:

- Unterhaltung

- Bildung

- Medizin

- Altenpflege

Einige Wirtschaftswissenschaftler schätzen, dass im nächsten Jahrzehnt über eine Milliarde humanoider Roboter hergestellt werden könnten.

Ein Kommentar dazu lautet: „Es gibt keine Zukunft, in der humanoide Roboter keine Gesichter haben. Und wenn sich ihre Augen und Lippen nicht korrekt bewegen, werden sie für immer seltsam bleiben.“

Dieses Projekt ist Teil einer langen Forschungsreise, die sich über mehr als zehn Jahre erstreckt und zum Ziel hat, Robotern beizubringen, mit Menschen zu kommunizieren, anstatt sie mit starren Regeln zu programmieren.

Abschließend heißt es: „Es geschieht etwas Bezauberndes, wenn ein Roboter lernt zu lächeln oder zu sprechen, einfach indem er Menschen beobachtet und ihnen zuhört. Selbst als erfahrener Robotiker kann ich nicht anders, als zu lächeln, wenn der Roboter mich spontan anlächelt.“